データセンターの熱管理 2026-2036年:技術、市場、機会Thermal Management For Data Centers 2026-2036: Technologies, Markets, and Opportunities 空冷、単相/二相D2C/液浸冷却、および関連コンポーネントを含む、データセンターの冷却技術およびコンポーネントのきめ細かな10年予測。データセンターコンポーネントのTIM2を包括的に分析。 AI、クラウ... もっと見る

サマリー空冷、単相/二相D2C/液浸冷却、および関連コンポーネントを含む、データセンターの冷却技術およびコンポーネントのきめ細かな10年予測。データセンターコンポーネントのTIM2を包括的に分析。

AI、クラウドコンピューティング、暗号マイニングなどの分野で高性能コンピューティングの需要が高まる中、チップの熱設計消費電力(TDP)は過去16年間で大幅に上昇している。2025年初頭にリリースされたニビダのB300 GPUは、NVラックが140kWの総電力を要求し、すでに1400WのTDPを実証している。Nvidiaが発表した次世代Rubinチップのロードマップや、MI400のような今後登場する同様の競合製品によって、TDPが1500kWを超えるチップが間もなく登場するとIDTechExは見ている。このようなTDPの上昇傾向は、マイクロレベル(半導体パッケージ内部、オンチップ、オンサーバー)とマクロレベル(サーバーラックや設備)の両方において、より効率的な熱管理システムの必要性を促している。近年、大手データセンターのハイパースケーラーやコロケーターは、様々な冷却部品サプライヤー、サーバーODM(相手先ブランドによる設計)メーカー、システムインテグレーター、ファブレス設計者と協力し、革新的なパイロットプロジェクトを立ち上げ、すぐに使える冷却ソリューションを商品化している。

IDTechExのレポート「データセンターの熱管理 2026-2036」は、冷却技術(単相D2C、二相D2C、単相液浸、二相液浸など)をセグメント化したデータセンターの冷却技術のきめ細かな市場予測をカバーしています。本レポートでは、液冷に不可欠なコンポーネントの技術的および商業的な詳細分析に加え、冷却バリューチェーンの内訳、さまざまな冷却方式の技術的障壁、バリューチェーンの異なるポジションにいるプレーヤーのコスト分析、バリューチェーンの統合可能性、将来の冷却戦略のロードマップを掲載しています。

技術的な分析に加え、データセンター冷却のバリューチェーン、バリューチェーン全体におけるプレイヤー間のパートナーシップ、主要プレイヤーの液体冷却サプライヤーの概要、競合環境分析など、包括的な商業的展望も分析しています。

本レポートでは、液冷の詳細な数量予測および市場規模予測を、配管/バルブ/モニタリング、液浸用CDU、液浸クーラント、液浸タンク、ヒートシンク、3Dベーパーチャンバー、D2C用CDU、サイドカー、リアドア熱交換器(RDHx)、ファン、クイックディスコネクト、マニホールド、コールドプレートシステム(コールドプレート、ホース、パイプ、サーバー内の流体分配ネットワークを含む)などのコンポーネント別にお届けします。また、液浸冷却については、液浸タンク、液浸クーラント、CDU、関連配管、バルブ、監視システムごとに細分化した詳細な予測を提供している。さらに、単相冷却技術と二相冷却技術に分けて予測しています。

また、データセンターコンポーネントのサーマルインターフェイス材料(TIM)の使用に関する10年間の展望も示しており、これにはTIM2sや先端プロセッサ用のTIM1s/TIM1.5sなどが含まれる。さらに、AIと非AIアプリケーションを区別した液冷採用の予測も掲載し、最も大きなビジネスチャンスが期待される業界を明らかにしている。

冷却の概要

データセンターの冷却方法は、採用する冷却媒体によって空冷と液冷に大別される。空冷は、対流を利用してサーバーから熱を放散させる空調および/またはファンに依存する。長い実績があるため、広く採用されている。しかし、空気の比熱が低いため、増大する冷却能力要件を満たすのは困難です。さらに、データセンター利用者がサーバー(通常は1Uサーバー)を高密度に配置することでラックスペースの利用率を最大化しようとするため、サーバー間の空隙が狭くなり、空冷の効率がさらに低下する。

一方、液冷は液体の高い比熱を利用して優れた冷却性能を実現します。液冷は、液体がどの部品に接触するかによって、ダイレクト・ツー・チップ/コールドプレート冷却、スプレー冷却、液浸冷却に分類される。ダイレクト・ツー・チップ冷却では、GPUなどの熱源の上に冷却液を入れたコールドプレートを直接取り付け、その間に熱界面材料(TIM)を塗布します。コールドプレート冷却(単相コールドプレートと二相コールドプレートの両方を含む)は、特定の構成に応じて、1.02~1.20の部分的電力使用効率(pPUE)を達成できます。

新たな選択肢は、サーバーを冷却液に完全に浸す浸漬冷却で、熱源と冷却液の直接接触が可能になり、最小pPUE 1.01で最高の冷却性能を達成します。しかし、高い初期費用(US$/ワット)、メンテナンス、サーバーボードの改造の複雑さなどの課題により、その普及はまだ限られている。とはいえ、液浸冷却は効率的な熱放散により長期的なエネルギー節約の可能性を秘めており、エネルギー危機という現在の状況を考えると、経済的に有益であるだけでなく、大企業が長期的に持続可能性の目標を達成するのにも役立ちます。

IDTechExによる4地域にわたるD2C冷却、1-PICおよび2-PIC浸漬の10年間の総所有コスト(TCO)の比較分析によると、レポートに記載された前提条件下で、10年間の平均でD2Cは1-PIC浸漬よりTCOが13%低く、2-PIC浸漬より9.4%低いことが明らかになった。また、本レポートでは、データセンターのエンドユーザー、サーバーOEM、液浸冷却ベンダー間の戦略的協力関係やパイロットプロジェクト、液浸冷却の普及を妨げるその他の障壁についても取り上げています。空冷、コールドプレート、液浸冷却について、2036年までの市場導入台数(ハードウェア単位)と収益予測を掲載しています。

液冷は、単相冷却と二相冷却に分類することもできる。二相冷却は一般的に高い効果を示すが、パーフルオロアルキルおよびポリフルオロアルキル物質(PFAS)に基づく二相浸漬冷媒に関する規制、相変化時の圧力上昇に耐えるための流体容器の機械的強度要件、気化による流体損失、流量の増加に伴う圧力損失、メンテナンスの複雑さとコストの高さなどの課題もある。単相冷却と二相冷却の基本的な動作原理は異なり、単相冷却は対流による熱放散に依存するのに対し、二相冷却剤は主に相変化時の潜熱による熱放散に依存する。本レポートでは、さまざまな液冷ベンダー、冷却液サプライヤー、データセンターのエンドユーザーを分析し、単相および二相のダイレクト・ツー・チップ/コールドプレートおよび液浸冷却に関連する機会と脅威に関する洞察を提供します。

2.5Dおよび3Dパッケージング技術の進歩に伴い、マイクロ流体冷却ソリューションの可能性とともに、先端半導体パッケージングにおける高性能TIM1材料へのニーズが高まっている。IDTechExのレポート「データセンター向け熱管理 2026-2036年」は、先端半導体パッケージング向けTIM1材料の分析を提供し、2026年から2036年までの市場規模を予測している。

IDTechExでは、データセンターの高性能化、ハイパースケールデータセンターの台頭、すぐに使える液冷ソリューションの入手可能性、高い柔軟性と後付け可能性、Nvidiaなどの大手企業が牽引する市場動向などの要因により、液冷の採用が急速に進むと予測している。特に、コールドプレート冷却は、費用対効果が高く、既存の空冷式データセンターとの互換性があるため、液浸冷却ソリューションに対応するための大規模な改修が不要であることから、最大の成長が見込まれる。

こうした予測に基づき、本レポートでは、データセンターにおける液冷関連ハードウェアの10年間の収益予測を、AI用途と非AI用途に分けて詳細に示している。非AI用途の中では、IDTechExはコールドプレート冷却の予測もサーバーラックの出力別に分けている。

市場機会

液冷の採用が進むにつれ、新たな機会が生まれ、データセンターの冷却サプライチェーンに関わる企業間の連携強化につながっている。冷却液分配ユニット(CDU)ベンダー、ポンプベンダー、冷却液サプライヤーなどの部品サプライヤーは、液冷の採用拡大から恩恵を受けることが予想される。CDUとポンプは、液冷システムの流量を制御するための重要なコンポーネントである。圧力損失などの要因を慎重に考慮する必要があります。本レポートでは、さまざまな市販のインラックCDUとインローCDUを紹介するとともに、動的粘度、密度、比熱、熱伝導率、必要な配管長や配管径に基づく冷却液の包括的な比較を行っている。

垂直統合の新たなトレンドの一つは、データセンターの冷却バリューチェーンに見られます。多くの液冷ソリューションサプライヤーは、バリューチェーン全体での協力体制の強化を提唱していますが、現在の状況は断片的で混沌としており、データセンターにあらゆるコンポーネントを統合するためには、システム統合による大規模な作業が必要です。IDTechExは、サーバーOEMが包括的なラックレベルの冷却ソリューションを提供し始めていることから、市場統合の潜在的な機会を特定した。これらのソリューションには、サーバー上のコールドプレート、サーバーラック、マニホールド、CDU、QDなどの重要部品など、さまざまなコンポーネントが含まれる。IDTechExはまた、液冷コンポーネントのサプライチェーンについてもまとめており、主要プレーヤーやその能力、バリューチェーンにおける企業間の連携などを掲載している。

主要な側面

本レポートは、複数のソリューションカテゴリーにわたるデータセンター冷却技術に関する重要な市場情報を提供している。

これには

目次1.要旨

1.1.TDPトレンド:履歴データと予測データ - GPU

1.2.TDPトレンド:履歴データと予測データ - CPU

1.3.増加し続けるデータセンターの電力需要と熱需要

1.4.冷却方法の概要

1.5.チップレベルでのさまざまな冷却

1.6.冷却方式別年間売上高予測:2022-2036年

1.7.液冷の年間売上高予測:2022-2036年

1.8.液冷データの年間売上高予測:2022-2036年

1.9.冷却システムのコスト分析

1.10.液浸冷却の年間売上高予測:2022-2036年

1.11.冷却技術の比較

1.12.データセンターの効率-分析的進化

1.13.空冷

1.14.液冷-ダイレクト・ツー・チップ/コールドプレートと液浸

1.15.液冷-単相と二相

1.16.二相D2C冷却の放熱経路

1.17.単相および二相コールドプレートの年間台数予測:2022-2036年

1.18.浸漬タンクの年間台数予測:2022-2036年

1.19.冷却剤の比較

1.20.冷却材の比較-PFAS規制

1.21.冷却液分配ユニット(CDU)

1.22.熱伝達-熱界面材料(TIMs)(1)

1.23.熱伝達-熱界面材料(TIMs)(2)

1.24.冷却コスト分析

1.25.OPEXとTCOの見積もり

1.26.直接チップ冷却、液浸冷却、空冷の価格設定-US$/Watt

2.はじめに

2.1.概要

2.1.1.増加し続けるデータセンターの電力需要と熱需要

2.1.2.データセンター設備-トップレベルの概要

2.1.3.データセンターのサーバーラックとサーバー構造

2.1.4.電力使用の効果

2.1.5.データセンターのスイッチトポロジー-3レイヤーとスパインリーフアーキテクチャ

2.1.6.Kファットツリー・トポロジー

2.2.データセンターの熱管理の概要

2.2.1.データセンターの熱管理ニーズ

2.2.2.データセンターのダウンタイムがもたらす重大な影響

2.2.3.データセンター立地の選択

2.2.4.TDPの増加による熱管理の効率化

2.2.5.データセンターの熱管理方法の概要

2.2.6.熱管理の分類

2.3.熱設計電力(TDO)の進化

2.3.1.TDP の歴史的データ-GPU

2.3.2.TDPの推移:過去データと予測データ-CPU

2.3.3.NvidiaのチップのTDP動向

3.熱管理方法

3.1.データセンターの冷却分類の紹介

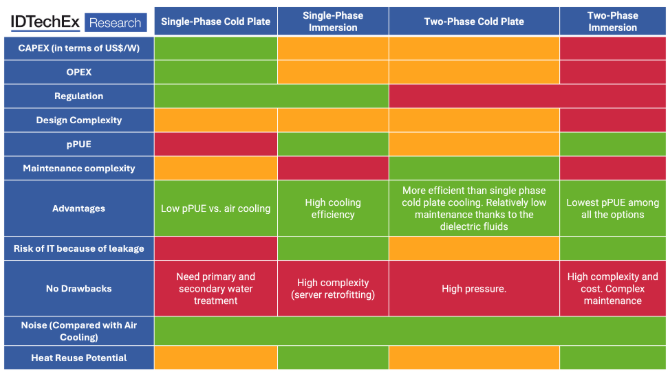

3.2.冷却技術の比較 (1)

3.3.冷却技術の比較(2)

3.4.空冷

3.5.液体と空気のハイブリッド冷却

3.6.ハイブリッド液冷

3.7.ハイブリッド液冷

3.8.ハイブリッド冷媒-冷媒冷却

4.空冷

4.1.概要

4.1.1.空冷入門(1)

4.1.2.空冷入門(2)

4.1.3.空冷方式の利点と欠点

4.1.4.使用例ロウレベル冷却 Liebert® CRV CRD25

4.1.5.概要RDHx

4.1.6.ハイブリッド空気-液体冷却-nVent

4.1.7.冷却塔-断熱冷却

4.1.8.水使用量と電力使用量のバランス-ケース・バイ・ケースの実際

4.1.9.ユースケース-Jaeggi-断熱型およびハイブリッド型ドライクーラー

4.1.10.データセンターにおける空冷の動向

4.2.空冷の予測

4.2.1.空冷ラックの割合

4.2.2.TCO 比較

5.液冷の概要

5.1.液冷と液浸冷却

5.2.液冷技術の比較 (1)

5.3.液冷技術の比較 (2)

5.4.液冷-ラックレベルでの冷却の違いによる電力制限

5.5.チップレベルでの冷却の違い

5.6.電力別データセンター

5.7.電力別液冷データセンター・サーバーラック

5.8.電力別液冷データセンター・サーバーラック

6.コールドプレート

6.1.概要

6.1.1.コールドプレート/チップ直接冷却-独立型コールドプレート

6.1.2.液体冷却コールドプレート

6.1.3.サーバーボードにおけるコールドプレート/チップ直接冷却

6.1.4.コールドプレート冷却の利点と欠点

6.1.5.コールドプレート要件

6.1.6.コールドプレート設計の考慮点(1)

6.1.7.コールドプレート設計の考慮事項 (2)

6.1.8.コールドプレートシステムの熱コスト分析 (1)

6.1.9.コールドプレートシステムの熱コスト分析-(2)

6.1.10.単相および二相 D2C 冷却の性能比較

6.1.11.単相および二相 D2C 冷却の冷却出力密度

6.1.12.液冷技術の定義(1)

6.1.13.液体冷却技術定義(2)

6.2.単相コールドプレート

6.2.1.単相コールドプレートに関する考察

6.2.2.IEI インテグレーション社

6.2.3.単相コールドプレートが優勢な理由

6.2.4.使用例Nvidia シリコンフォトニクス共同パッケージ光学系コールドプレート冷却

6.3.二相コールドプレート

6.3.1.二相D2C-高い熱性能だが、ハードウェア設計は異なる

6.3.2.二相D2Cの利点 (1/3)

6.3.3.二相D2Cの利点 (2/3)

6.3.4.二相D2Cのメリット(3/3)

6.3.5.二相D2C冷却の放熱経路

6.3.6.Wieland Group-二相蒸発器/コールドプレート

6.3.7.パッシブ・コールドプレート冷却-Frigel & Neurok Thermocon

6.3.8.例ダイレクト・ツー・チップ冷却

6.3.9.タイソン-パッシブ二相冷却

6.3.10.パッシブ・ループ・ヒートパイプ(LHP)

6.3.11.ユースケースCalyos

6.3.12.直接水冷サーバー-ABB

6.3.13.二相コールドプレートのコールドプレートと部品材料の選択

6.3.14.熱性能試験結果-Accelsius

6.4.コールドプレートの予測

6.4.1.AI および非 AI の年間コールドプレート数予測:2022-2036年

6.4.2.単相および二相コールドプレートの年間台数予測:2022-2036年

6.4.3.単相および二相コールドプレートの市場シェア予測:2022-2036年

6.4.4.非 AI 用(主に HPC)コールドプレートの年間生産台数予測:2026-2036年

6.4.5.非AI(主にHPC)用コールドプレートの年間予測データ表: 2026-2036年

6.4.6.コールドプレートの総コスト分析 (コールドプレート + QD + マニホールド、ホースなど)

6.4.7.GPU および CPU コールドプレートシステムの予測:2025-2036年

6.4.8.コールドプレートの年間収益予測概要: 2022-2036年

6.4.9.コールドプレートの年間収益予測2022-2036年

6.4.10.CPU と GPU のコールドプレートの年間収益予測: 2025-2035年 6.5:2025-2035

6.5.コールドプレート冷却の概要

6.5.1.概要コールドプレート

6.5.2.コールドプレートの構造

6.5.3.コールドプレート冷却の利点と課題 (1)

6.5.4.コールドプレート冷却の利点と課題 (2)

6.5.5.コールドプレート冷却の限界

6.5.6.コールドプレート冷却のまとめ-考慮事項

6.5.7.コールドプレートシステムの熱コスト分析 (1)

6.5.8.コールドプレートシステムの熱コスト分析-(2)

7.スプレー冷却

7.1.スプレー冷却の紹介

7.2.先進液体冷却技術(ALCT)-スプレー冷却

8.液浸冷却

8.1.概要

8.1.1.単相・二相浸漬-概要(1)

8.1.2.単相液浸冷却(2)

8.1.3.SWOT:単相浸漬冷却

8.1.4.概要二相冷却

8.1.5.SWOT:二相冷却

8.2.単相

8.2.1.ユースケース: Iceotope - ダイレクト・ツー・チップ + 浸漬

8.2.2.ユースケース:LiquidCoolソリューション - (1)

8.2.3.ユースケースリキッドクール・ソリューション-(2)

8.2.4.ユースケース: グリーン革命冷却 (GRC)

8.2.5. nVent/Iceotope と LiquidCool ソリューション-限定的な差別化

8.2.6.DCX 液冷-液浸

8.3.二相

8.3.1.Wieland-二相液浸冷却

8.3.2.二相冷却-離陸前のフェーズアウト?

8.3.3.二相冷却のロードマップ

8.3.4.単相液浸冷却のロードマップ

8.3.5.例液浸

8.3.6.使用例:アイスオトープとメタ

8.3.7.ユースケースマイクロソフト

8.3.8.ユースケースマイクロソフト、海中データセンターを停止

8.3.9.アスペリタス

8.3.10.ギガバイト

8.3.11.まとめ(1)-水中冷却のメリット

8.3.12.まとめ(2)-無浸漬冷却の課題

8.3.13.コスト削減の比較-液浸冷却と空冷

8.3.14.液冷方式の比較

8.3.15.ダイレクト・ツー・チップ、液浸、空冷の価格-US$/ワット

8.3.16.液浸タンク年間台数予測:2022-2035年

8.3.17.液浸冷却の売上予測:2022-2036年

9.マイクロ流体冷却

9.1.1.HPC向けベンチマーク冷却技術

9.1.2.マイクロ流体の概要

9.1.3.HPC パッケージの冷却構成のベンチマーク

9.1.4.マイクロチャンネルの研究-性能ベンチマーク

9.1.5.マイクロチャンネルヒートシンクアーキテクチャーの設計原理と課題-1

9.1.6.マイクロチャネル・ヒートシンク・アーキテクチャーの設計原理と課題-2

9.1.7.冷却用ウェーハレベル・マイクロチャネルの統合

9.1.8.マイクロチャネルシステムの熱設計上の考慮事項と冷却液の選択

9.1.9.マイクロチャンネルの統合とシステム採用の障壁

9.1.10.マイクロソフト-シリコン一体型マイクロ流体冷却

9.1.11.マイクロ流体冷却ヒートシンクの構造と製造

9.1.12.HPC 向けオンパッケージ液冷

9.1.13. IMEC-マイクロ流体冷却(1/2)

9.1.14.TIM オプションとパッケージ内液冷を備えたインテル・ファウンドリの熱能力

9.1.16.IBM z17

9.1.17.マイクロ流体冷却ASPユニット予測:2026-2036年

10.冷却剤

10.1.液浸クーラント

10.1.1.冷却液の紹介

10.1.2.冷却液の比較-使用温度

10.1.3.冷却液の熱伝導率

10.1.4.傾向-フッ素系化学物質の減少?

10.1.5.浸漬型クーラント液サプライヤー

10.1.6.エンジニアード・フルード-なぜオイルより優れているのか

10.1.7.二相冷却における冷却液のロードマップは?

10.1.8.ハネウェル社のR-1233zdとケムール社のOpteon SF33

10.1.9.無浸漬冷却剤の標準化への要求-FOMs

10.1.10.実績値(FOM)

10.1.11.単相浸漬用力対流 FOM

10.1.12.FOM3-圧力降下に対する粘度

10.1.13.密度

10.1.14.シグナルインテグリティ評価

10.1.15.地球温暖化係数(GWP)

10.1.16.材料適合性ガイド-浸漬クーラントとTIM/接着剤

10.1.17.材料適合性ガイド-シール/ガスケット/Oリングと浸漬クーラント

10.1.18.材料適合性ガイド-プラスチックと浸漬クーラント

10.1.19.材料適合性ガイド-パイプ&フィッティングと浸漬クーラント

10.1.20.材料適合性ガイド-金属と浸漬クーラント

10.1.21.年間浸漬クーラント量:2022~2036年

10.1.22.PFASタイプの概要、ポストPFASブレンド、PFASフリーのデータセンター冷却剤代替品

10.1.23.使用中の冷媒と技術動向のマッピング

10.1.24.採用予測と性能評価

10.1.25.比較優位性と限界

10.1.26.規制上の障壁

10.1.27.さまざまな冷媒のクラス

10.2.D2C冷媒

10.2.1.二相DLC用冷媒 (1/2)

10.2.2.二相DLC用冷媒(2/2)

10.2.3.熱可塑性プラスチックとエラストマーへの適合性

10.2.4.単相D2C用PGベース冷媒の特性

11.サプライチェーン、パートナーシップ、ロードマップ

11.1.1.データセンター冷却バリューチェーン

11.1.2.冷却ソリューションパートナー

11.1.3.冷却ソリューションサプライヤーの概要

11.1.4.主要企業とその顧客の概要

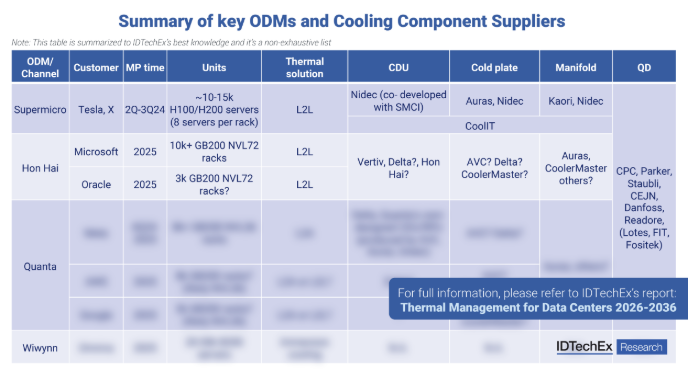

11.1.5.主要 ODM および冷却部品サプライヤーの概要

11.1.6.コールドプレートメーカーの市場シェア

11.1.7.サーバーサプライチェーン

11.1.8.サーバー冷却部品のコスト分析

11.1.9.Nvidiaの液冷サプライチェーン-2025年

11.1.10.インテルとサブマー-熱再利用と液浸冷却

11.1.11.アイストーン、インテル、HPE

11.1.12.Iceotope、Schneider Electric、Avnet-液冷データセンター

11.1.13.GRC とインテル

11.1.14.GRCとデル-エッジ・デプロイメント

11.1.15.Iceotope と Meta

11.1.16.新しい無電解クーラントの開発-ElectroSafe

11.1.17.パートナーシップ-バリューチェーンはどのように見えるか?

11.1.18.液冷採用のロードマップ

11.1.19.データセンター冷却ソリューション-ロードマップ

12.総所有コスト分析

12.1.冷却コスト分析

12.2.OPEX と TCO の見積もり

12.3.TCO 比較-投資回収時間

12.4.ダイレクト・ツー・チップ、液浸、空冷の価格設定-US$/ワット

12.5.チラー付きD2CのTCO分析

12.6.チラー付き1-PICのTCO分析

12.7.TCO 分析-10 年間

12.8.冷却システムコスト-直接チップ冷却ハードウェア

12.9.液浸冷却コスト-コンポーネントと設備レベル

12.10.冷却システムコスト-CDUハードウェア

12.11.コスト-流体

12.12.冷却システムコスト-サーマルインターフェイス材料

13.冷却液分配ユニット(CDU)

13.1.概要

13.1.1.概要

13.1.2.インロー CDU とインラック CDU の傾向

13.1.3.冗長性-(1)

13.1.4.冗長性-(2)

13.1.5.液対液(L2L)CDU

13.1.6.液体対空気 CDU

13.1.7.液冷と空冷のまとめ

13.1.8.Vertiv-Liebert® XDU 60 熱交換器および CDU-(1)

13.1.9.Vertiv-Liebert® XDU 熱交換器および CDU-(2)

13.1.10.CDU-nVent

13.1.11.CDU-CoolIT-ティアダウン(1)

13.1.12.CDU-CoolIT-ティアダウン (2)

13.1.13.CDU-CoolIT-ティアダウン (3)

13.1.14.CDU ティアダウン-Motivair

13.1.15.LiquidStack の液-液クーラント分配ユニット(CDU)

13.1.16.Boyd-コールドプレートとCDU (1/2)

13.1.17.Boyd-コールドプレートと CDU (2/2)

13.1.18.CDU-冷却能力評価

13.1.19.CDU の収益予測: 2022-2036年

13.2.メインポンプ

13.2.1.概要

13.2.2.冗長性分析

13.3.フィルタリング

13.3.1.概要

13.3.2.フィルター-概略図

13.3.3.フィルター

13.4.センサー

13.4.1.センサーの概要

13.4.2.漏洩検知センサー-概要

13.4.3.サーバーノード上の漏洩検知センサー(1)

13.4.4.サーバーノード上の漏水検知センサー(2)

13.5.クイックディスコネクト(QD)

13.5.1.QDの概要

13.5.2.接液材料

13.5.3.クイックディスコネクト-コストと操作要件

13.6.熱の再利用

13.6.1.データセンター冷却における熱再利用の概要

13.6.2.ユースケース:アマゾンデータセンターの熱再利用

13.6.3.フェイスブック(現メタ)データセンターの熱再利用

13.6.4.テンセント-天津データセンターの熱を都市暖房に

13.6.5.熱再利用の投資利益率

13.6.6.熱再利用のその他の例

13.6.7.熱再利用のその他の例

14.熱伝導-熱界面材料(TIMS)

14.1.TIM2の概要

14.1.1.データセンターにおける熱インターフェース材料

14.1.2.データセンターにおける一般的な TIM の種類-ラインカードレベル

14.1.3.データセンターにおける TIM-ラインカードレベル-トランシーバ

14.1.4.サーバーボードにおける TIM

14.1.5.サーバーボードのレイアウト

14.1.6.データセンターの TIM-サーバーボード、スイッチ、ルーター

14.1.7.データセンターのスイッチプレーヤー

14.1.8.データセンター・スイッチでの TIM の使用方法-FS N8560-32C 32x 100GbE スイッチ

14.1.9.WS-SUP720 スーパーバイザー 720 モジュール

14.1.10.Ubiquiti UniFi USW-Leaf スイッチ

14.1.11.FS S5850-48S6Q 48x 10GbE および 6x 40GbE スイッチ

14.1.12.Cisco Nexus 7700 Supervisor 2E モジュール

14.1.13.電源コンバータの TIM (1):AC-DC および DC-DC

14.1.14.データセンター電源システム

14.1.15.データセンター電源用TIM(2)

14.1.16.データセンター電源のTIM(3)

14.1.17.データセンター電源における TIM(4)

14.1.18.データセンター電源における TIM の使用方法 (5)

14.1.19.データセンター電源におけるTIMの使用方法 (6)

14.1.20.データセンター用 TIM-電源コンバータ

14.1.21.TIM 形状の違い-(1)

14.1.22.TIM 形状の違い-(2)

14.1.23.新素材-高軟質層状金属フォーム(1)

14.1.24.新素材-柔軟性の高い層状金属フォーム (2)

14.1.25.データセンターにおけるTIMの動向

14.1.26.サーバーボードのTIM面積の推定

14.1.27.サーバー数予測:2021-2035

14.1.28.液浸冷却における TIM 要件

14.1.29.液浸冷却の一般的な TIM

14.1.30.スイッチあたりの TIM 面積

14.1.31.リーフおよびスパインスイッチのTIM面積

14.1.32.リーフおよびスパインスイッチの年間 TIM 面積予測:2026-2036年

14.1.33.データセンター電源における TIM 消費量

14.1.34.予測概要-さまざまなデータセンターコンポーネントの年間 TIM 面積 (m2) 予測:2026-2036 年

14.1.35.データセンターコンポーネントの年間 TIM 収入予測(百万米ドル):2026-2036 年

14.2.先端半導体パッケージにおける TIM1 と TIM1.5

14.2.1.パッケージ内部の熱インターフェース材料-TIM1

14.2.2.将来考えられるTIM1オプション

14.2.3.TIM1に関する考察

14.2.4.インジウム箔 TIM1-マルチ・リフロー・プロセスの問題点

14.2.5.伝統的で成熟した製品-BGA用シンエツX-23シリーズ

14.2.6.サーマルゲル-信越MicroSi

14.2.7.TIM1とTIM1.5のASP市場規模予測:2026年-2036年

15.予測概要

15.1.冷却方式別年間売上高予測:2022-2036年

15.2.冷却方式別年間売上高予測-データテーブル: 2022-2036年

15.3.液冷の年間売上高予測:2022-2036年

15.4.液冷データ年間収益予測:2022-2036年

15.5.液冷の年間販売台数予測:2022-2036年

15.6.冷却データテーブルの年間販売台数予測: 2022-2036年

16.プロファイル

16.1.Accelsius -Two-Phase Direct-to-Chip Cooling

16.2.アマゾンAWSデータセンター

16.3.Arieca

16.4.Arieca

16.5.Asperitas Immersed Computing

16.6.カリオスデータセンター・アプリケーション

16.7.エンジニアード・フルイド

16.8.グリーン・レボリューション・クーリング(GRC)

16.9.ヘンケル:マイクロTIMとデータセンター

16.10.LiquidCool Solutions -シャーシベースの液浸冷却

16.11.LiSAT

16.12.LiSAT

16.13.ナノジョイント

16.14.ネオファン

16.15.ニューロック・サーモコン

16.16.パーカー・ロードディスペンサブル・ギャップフィラー

16.17.レゾナック・ホールディングス

16.18.住友化学

16.19.タイボー(上海)環境技術有限公司

16.20.タイソン

16.21.バーティブ・ホールディングス-データセンター液冷

16.22.ズータコア

SummaryGranular ten-year forecast for data center cooling technologies and components, including air cooling, single-phase/two-phase D2C/immersion cooling and their associated components. Comprehensive analysis of TIM2 for data center components.

With the increasing demand for high-performance computing in sectors like AI, cloud computing, and crypto mining, the thermal design power (TDP) of chips has risen significantly over the past 16 years. Nivida's B300 GPU, released in early 2025, has already demonstrated a TDP of 1400W with its NV rack demanding a total power of 140kW. With the roadmap released by Nvidia on its next-generation Rubin chip and similar upcoming competitors such as MI400, IDTechEx believes we will soon see chips with TDP over 1500kW. This upward trend in TDP has propelled a need for more efficient thermal management systems at both the micro (inside semiconductor packaging, on-chip, and on-server) and macro (server rack and facility) levels. In recent years, leading data center hyperscalers and colocators have collaborated with various cooling component suppliers, server ODMs (original design manufacturers), system integrators, and fabless designers, to launch innovative pilot projects and commercialize ready-to-use cooling solutions, aiming to enhance cooling performance and meet sustainability targets by adopting more efficient cooling solutions.

IDTechEx's report, "Thermal Management for Data Centers 2026-2036" covers a granular market forecast of data center cooling technologies segmented cooling technology (e.g., single-phase direct-to-chip (D2C), two-phase D2C, single-phase immersion, and two-phase immersion). The report conducts in-depth technical and commercial of essential components for liquid cooling, along with a breakdown of the cooling value chain, technological barriers of different cooling methods, cost analysis of players in different value chain positions, value chain consolidation potentials, and roadmap for the future cooling strategy.

In addition to technical analysis, a comprehensive commercial landscape, such as, data center cooling value chain, partnerships between players across the value chain, a summary of liquid cooling suppliers for leading players, and competitive landscape analysis has also been analyzed.

The report delivers an in-depth volume and market size forecast for liquid cooling, categorized by components including piping/valves/monitoring, CDUs for immersion, immersion coolant, immersion tanks, heat sinks, 3D vapor chambers, CDUs for D2C, sidecar, rear door heat exchanger (RDHx), fans, quick disconnects, manifolds, and cold plate systems (including cold plates, hoses, pipes, and fluid distribution networks within servers). It also offers a detailed forecast for immersion cooling, segmented by immersion tanks, immersion coolant, CDUs, and related piping, valves, and monitoring systems. Additionally, the forecast is further divided by single-phase and two-phase cooling technologies.

The report also provides a 10-year outlook on the use of thermal interface materials (TIM) for data center components, including TIM2s and TIM1s/TIM1.5s for advanced processors. Moreover, it includes a forecast of liquid cooling adoption, differentiating between AI and non-AI applications, to highlight the industries expected to present the most significant opportunities.

Cooling Overview

Data center cooling methods can be broadly categorized into air cooling and liquid cooling, depending on the cooling medium employed. Air cooling relies on air conditioning and/or fans, utilizing convection to dissipate heat from the servers. It has been widely adopted due to its long and successful track record. However, the low specific heat of air makes it challenging to meet the increasing cooling capacity requirements. Additionally, as data center users strive to maximize rack space utilization by densely packing servers (typically 1U servers), the air gaps between servers become narrower, which further reduces the efficiency of air cooling.

Liquid cooling, on the other hand, takes advantage of the higher specific heat of liquid to achieve superior cooling performance. Depending on the which components the fluids contact, liquid cooling can be classified into direct-to-chip/cold plate cooling, spray cooling, and immersion cooling. Direct-to-chip cooling involves mounting a cold plate with coolant fluid directly on top of heat sources such as GPUs, with a thermal interface material (TIM) applied in between. Cold plate cooling (including both single-phase and two-phase cold plates) can achieve a partial power use effectiveness (pPUE) ranging from 1.02 to 1.20, depending on the specific configuration.

An emerging alternative is immersion cooling where the servers are fully submerged in coolant fluids, enabling direct contact between the heat sources and the coolant, thereby achieving the best cooling performance with the lowest pPUE of 1.01. However, its widespread adoption is still limited due to challenges such as high upfront costs (in terms of US$/Watt), maintenance, and complexities of retrofitting the server boards. Nevertheless, immersion cooling holds potential for long-term energy savings thanks to their efficient thermal dissipation, which is not only economically beneficial given the current context of energy crisis but also helps the large companies to achieve their sustainability goals in the long run.

IDTechEx's comparative analysis of the 10-year total cost of ownership (TCO) between D2C cooling, 1-PIC and 2-PIC immersion across four regions reveals that over the course of 10 years, D2C on average has a 13% lower TCO than 1-PIC immersion and 9.4% lower than 2-PIC immersion, subject to the assumptions listed in the report. This report also highlights strategic collaborations and pilot projects between data center end-users, server OEMs, and immersion cooling vendors, as well as other barriers hindering the widespread adoption of immersion cooling. Market adoption (hardware units) and revenue forecasts are provided for air, cold-plate, and immersion cooling through to 2036.

Liquid cooling can also be classified into single-phase and two-phase cooling. Two-phase cooling generally exhibits greater effectiveness, but it also presents challenges such as regulations regarding two-phase immersion refrigerant based on perfluoroalkyl and polyfluoroalkyl substances (PFAS), mechanical strength requirements for fluid containers to withstand increased pressure during phase changes, fluid loss due to vaporization, pressure drop with increasing flow rate, and high maintenance complexities and costs. The fundamental operating principles of single- and two-phase cooling is different where single-phase cooling relies on the dissipating the heat through convection whereas two-phase coolant primarily rely on dissipating the heat through the latent heat during the phase change. This report provides an analysis of different liquid cooling vendors, coolant fluid suppliers, and data center end-users, offering insights into the opportunities and threats associated with single-phase and two-phase direct-to-chip/cold plate and immersion cooling.

As 2.5D and 3D packaging technologies advance, there is a growing need for high-performance TIM1 materials in advanced semiconductor packaging, along with potential microfluidic cooling solutions. IDTechEx's report, "Thermal Management for Data Centers 2026-2036" provides an analysis of TIM1 materials for advanced semiconductor packaging and forecasts its market size from 2026 to 2036.

IDTechEx anticipates rapid growth in the adoption of liquid cooling, driven by factors such as the increasing power of data centers, the rise of hyperscale data centers, the availability of ready-to-use liquid cooling solutions, high flexibility and ability to retrofit, and the market trends driven by large players such as Nvidia. Specifically, cold plate cooling is expected to experience the largest growth due to its cost effectiveness and compatibility with existing air-cooled data centers, eliminating the need for extensive retrofitting to accommodate immersion cooling solutions.

In line with these projections, this report offers a detailed 10-year revenue forecast for hardware related to liquid cooling in data centers segmented AI and non-AI applications. Within non-AI applications, IDTechEx also splits the forecasts of cold plate cooling by server rack power.

Market Opportunities

With greater adoption of liquid cooling, new opportunities are emerging, leading to strengthened collaborations among companies involved in the data center cooling supply chain. Component suppliers such as coolant distribution units (CDUs) vendors, pump vendors, and coolant fluid suppliers are expected benefit from the increased adoption of liquid cooling. CDUs and pumps are critical components for controlling the flow rate in liquid cooling systems. Factors such as pressure drop need to be carefully considered. This report introduces various commercial in-rack and in-row CDUs, accompanied by a comprehensive comparison of coolant fluids based on their dynamic viscosity, density, specific heat, thermal conductivity, as well as required pipe length and pipe diameter.

One of the emerging trends in vertical integration is seen in the data center cooling value chain, which is intricate and extensive. Although many liquid cooling solution suppliers advocate for increased collaboration across the value chain, the current landscape remains fragmented and chaotic, requiring extensive work from system integrations to integrate every component together into a data center. IDTechEx has identified potential opportunities for market consolidation, with server OEMs beginning to offer comprehensive rack-level cooling solutions. These solutions encompass various components, including cold plates on servers, server racks, and essential parts such as manifolds, CDUs, and QDs. IDTechEx has also summarizes the liquid cooling component supply chain, with leading players, their capacity, and collaboration across companies in the value chain.

Key Aspects

This report provides critical market intelligence on data center cooling technologies across multiple solution categories.

This includes

Table of Contents1. EXECUTIVE SUMMARY

1.1. TDP Trend: Historic Data and Forecast Data - GPU

1.2. TDP Trend: Historic Data and Forecast Data - CPU

1.3. Ever increasing data center power demand and thermal demand

1.4. Cooling Methods Overview

1.5. Different Cooling on Chip Level

1.6. Yearly Revenue Forecast By Cooling Method: 2022-2036

1.7. Summary of Yearly Revenue Forecast for Liquid Cooling: 2022-2036

1.8. Summary of Yearly Revenue Forecast for Liquid Cooling Data: 2022-2036

1.9. Cost analysis of cooling systems

1.10. Yearly Immersion Cooling Revenue Forecast: 2022 - 2036

1.11. Cooling Technology Comparison

1.12. Data Center Efficiency - Analytical Evolution

1.13. Air Cooling

1.14. Liquid Cooling - Direct-to-Chip/Cold Plate and Immersion

1.15. Liquid Cooling - Single-Phase and Two-Phase

1.16. Heat dissipation path for two-phase D2C cooling

1.17. Yearly Number of Single- and Two-Phase Cold Plates Forecast: 2022-2036

1.18. Immersion Tank Yearly Number Forecast: 2022-2036

1.19. Coolant Comparison

1.20. Coolant Comparison - PFAS Regulations

1.21. Coolant Distribution Units (CDU)

1.22. Heat Transfer - Thermal Interface Materials (TIMs) (1)

1.23. Heat Transfer - Thermal Interface Materials (TIMs) (2)

1.24. Cooling cost analysis

1.25. OPEX and TCO Estimation

1.26. Pricing of Direct-to-Chip, Immersion and Air Cooling - US$/Watt

2. INTRODUCTION

2.1. Overview

2.1.1. Ever increasing data center power demand and thermal demand

2.1.2. Data Center Equipment - Top Level Overview

2.1.3. Data Center Server Rack and Server Structure

2.1.4. Power Use Effectiveness

2.1.5. Data Center Switch Topology - Three Layer and Spine-Leaf Architecture

2.1.6. K-ary Fat Tree Topology

2.2. Data Center Thermal Management Overview

2.2.1. Thermal Management Needs for Data Centers

2.2.2. Significant Consequences for Data Center Downtime

2.2.3. Data Center Location Choice

2.2.4. Increasing TDP Drives More Efficient Thermal Management

2.2.5. Overview of Thermal Management Methods for Data Centers

2.2.6. Thermal Management Categorization

2.3. Thermal Design Power (TDO) Evolution

2.3.1. Historic Data of TDP - GPU

2.3.2. TDP Trend: Historic Data and Forecast Data - CPU

2.3.3. Nvidia's Chips TDP Trend

3. THERMAL MANAGEMENT METHODS

3.1. Introduction to Data Center Cooling Classification

3.2. Cooling Technology Comparison (1)

3.3. Cooling Technology Comparison (2)

3.4. Air Cooling

3.5. Hybrid Liquid-to-Air Cooling

3.6. Hybrid Liquid-to-Liquid Cooling

3.7. Hybrid Liquid-to-Refrigerant Cooling

3.8. Hybrid Refrigerant-to-Refrigerant Cooling

4. AIR COOLING

4.1. Overview

4.1.1. Introduction to Air Cooling (1)

4.1.2. Introduction to Air Cooling (2)

4.1.3. Benefits and Drawbacks of Air-Cooling Methods

4.1.4. Use Case: Row-Level Cooling Liebert® CRV CRD25

4.1.5. Overview: RDHx

4.1.6. Hybrid Air-to-Liquid Cooling - nVent

4.1.7. Cooling Tower - Adiabatic Cooling

4.1.8. Balance Between Water Use and Power Use - Case by Case in Practice

4.1.9. Use Case: Jaeggi - Adiabatic and Hybrid Dry Coolers

4.1.10. Trend for Air Cooling in Data Centers

4.2. Air Cooling Forecasts

4.2.1. Percentage of Air-Cooled Racks

4.2.2. TCO Comparison

5. LIQUID COOLING OVERVIEW

5.1. Liquid Cooling and Immersion Cooling

5.2. Comparison of Liquid Cooling Technologies (1)

5.3. Comparison of Liquid Cooling Technologies (2)

5.4. Liquid Cooling - Power Limitation of Different Cooling on Rack Level

5.5. Different Cooling on Chip Level

5.6. Data Center By Power

5.7. Liquid-Cooled Data Center Server Rack by Power

5.8. Liquid-Cooled Data Center Server Rack by Power

6. COLD PLATES

6.1. Overview

6.1.1. Cold Plate/Direct to Chip Cooling - Standalone Cold Plate

6.1.2. Liquid Cooling Cold Plates

6.1.3. Cold Plate/Direct to Chip Cooling in Server Boards

6.1.4. Benefits and Drawbacks of Cold Plate Cooling

6.1.5. Cold Plate Requirements

6.1.6. Considerations for Cold Plate Design (1)

6.1.7. Considerations for Cold Plate Design (2)

6.1.8. Thermal Cost Analysis of Cold Plate System - (1)

6.1.9. Thermal Cost Analysis of Cold Plate System - (2)

6.1.10. Performance comparison of single-phase and two-phase D2C cooling

6.1.11. Cooling power density of single- and two-phase D2C cooling

6.1.12. Liquid Cooling Technology Definitions (1)

6.1.13. Liquid Cooling Technology Definitions (2)

6.2. Single-Phase Cold Plate

6.2.1. Single-Phase Cold Plate Considerations

6.2.2. IEI Integration Corp

6.2.3. Why Single-Phase Cold Plate Might Dominate

6.2.4. Use case: Nvidia silicone photonics co-packaged optics cold plate cooling

6.3. Two-Phase Cold Plate

6.3.1. Two-phase D2C - higher thermal performance but different hardware designs

6.3.2. Benefits of two-phase D2C (1/3)

6.3.3. Benefits of two-phase D2C (2/3)

6.3.4. Benefits of two-phase D2C (3/3)

6.3.5. Heat dissipation path for two-phase D2C cooling

6.3.6. Wieland Group - Two-Phase Evaporator/Cold Plate

6.3.7. Passive Cold Plate Cooling - Frigel & Neurok Thermocon

6.3.8. Examples: Direct-to-Chip Cooling

6.3.9. Tyson - Passive Two-Phase Cooling

6.3.10. Passive Loop Heat Pipes (LHP)

6.3.11. Use Case: Calyos

6.3.12. Direct Water-Cooled Server - ABB

6.3.13. Cold plate and component material selection for 2-phase cold plates

6.3.14. Thermal performance testing results - Accelsius

6.4. Cold Plate Forecast

6.4.1. Yearly Number of Cold Plate for AI and Non-AI Forecast: 2022-2036

6.4.2. Yearly Number of Single- and Two-Phase Cold Plates Forecast: 2022-2036

6.4.3. Market Share Forecast of Single- and Two-Phase Cold Plate: 2022-2036

6.4.4. Yearly Number of Cold Plate For Non-AI (mainly HPC) Forecast: 2026-2036

6.4.5. Yearly Number of Cold Plate For Non-AI (mainly HPC) Forecast Data Table: 2026-2036

6.4.6. Total Cost Analysis of Cold Plate (Cold plate + QD + Manifold, Hoses, etc.)

6.4.7. GPU and CPU Cold Plate System Forecast: 2025-2036

6.4.8. Yearly Revenue Forecast Summary of Cold Plate: 2022-2036

6.4.9. Yearly Cold Plate Revenue Forecast: 2022-2036

6.4.10. Yearly Revenue of Cold Plate of CPU and GPU: 2025-2035

6.5. Summary of Cold Plate Cooling

6.5.1. Overview: Cold Plate

6.5.2. Cold Plate Structure

6.5.3. Benefits and Challenges of Cold Plate Cooling (1)

6.5.4. Benefits and Challenges of Cold Plate Cooling (2)

6.5.5. Limitations of Cold Plate Cooling

6.5.6. Summary of Cold Plate Cooling - Considerations

6.5.7. Thermal Cost Analysis of Cold Plate System - (1)

6.5.8. Thermal Cost Analysis of Cold Plate System - (2)

7. SPRAY COOLING

7.1. Introduction to Spray Cooling

7.2. Advanced Liquid Cooling Technologies (ALCT) - Spray Cooling

8. IMMERSION COOLING

8.1. Overview

8.1.1. Single-Phase and Two-Phase Immersion - Overview (1)

8.1.2. Single-Phase Immersion Cooling (2)

8.1.3. SWOT: Single-Phase Immersion Cooling

8.1.4. Overview: Two-Phase Immersion Cooling

8.1.5. SWOT: Two-Phase Immersion Cooling

8.2. Single Phase

8.2.1. Use Case: Iceotope - Direct-to-Chip + Immersion

8.2.2. Use Case: LiquidCool Solutions - (1)

8.2.3. Use Case: LiquidCool Solutions - (2)

8.2.4. Use Case: Green Revolution Cooling (GRC)

8.2.5. nVent/Iceotope and LiquidCool Solutions - Limited Differentiation

8.2.6. DCX Liquid Cooling - Immersion

8.3. Two-Phase

8.3.1. Wieland - Two-Phase Immersion Cooling

8.3.2. Two-Phase Cooling - Phase Out Before Starting to Take Off?

8.3.3. Roadmap of Two-Phase Immersion Cooling

8.3.4. Roadmap of Single-Phase Immersion Cooling

8.3.5. Examples: Immersion

8.3.6. Use-Case: Iceotope and Meta

8.3.7. Use-Case: Microsoft

8.3.8. Use-Case: Microsoft Halted its Underwater Data Centers

8.3.9. Asperitas

8.3.10. Gigabyte

8.3.11. Summary (1) - Benefits of Immersion Cooling

8.3.12. Summary (2) - Challenges of Immersion Cooling

8.3.13. Cost Saving Comparison - Immersion and Air Cooling

8.3.14. Comparison of Liquid Cooling Methods

8.3.15. Pricing of Direct-to-Chip, Immersion and Air Cooling - US$/Watt

8.3.16. Immersion Tank Yearly Number Forecast: 2022-2035

8.3.17. Immersion Cooling Revenue Forecast: 2022-2036

9. MICROFLUIDIC COOLING

9.1.1. Benchmark Cooling Technologies for HPC

9.1.2. Microfluidic Overview

9.1.3. Benchmark of Cooling Configurations for HPC Packages

9.1.4. Microchannel studies - performance benchmark

9.1.5. Design Principles and Challenges of Microchannel Heat Sink Architecture - 1

9.1.6. Design Principles and Challenges of Microchannel Heat Sink Architecture - 2

9.1.7. Wafer-Level Microchannel Integration for Cooling

9.1.8. Thermal Design Considerations and Coolant Selection for Microchannel Systems

9.1.9. Barriers to Microchannel Integration and System Adoption

9.1.10. Microsoft - Integrated Silicon Microfluidic Cooling

9.1.11. Microfluidics Cooling Heatsink Structure and Manufacture

9.1.12. On-package liquid cooling for HPC

9.1.13. imec - microfluidic cooling (1/2)

9.1.14. imec - microfluidic cooling (2/2)

9.1.15. Intel foundry thermal capabilities with TIM options and in-package liquid cooling

9.1.16. IBM z17

9.1.17. Microfluidic cooling ASP unit forecast: 2026-2036

10. COOLANT

10.1. Immersion Coolant

10.1.1. Introduction to Cooling Fluid

10.1.2. Coolant Fluid Comparison - Operating Temperature

10.1.3. Thermal conductivity of coolant

10.1.4. Trend - Decline in Fluorinated Chemicals?

10.1.5. Immersion Coolant Liquid Suppliers

10.1.6. Engineered Fluids - Why Better Than Oils

10.1.7. What is the Roadmap for Coolant in Two-Phase Cooling?

10.1.8. Honeywell R-1233zd and Chemours' Opteon SF33

10.1.9. Demand for Immersion Coolant Standardization - FOMs

10.1.10. Figures of Merit (FOM)

10.1.11. Force Convection FOM for Single-Phase Immersion

10.1.12. FOM3 - Viscosity for Pressure Drop

10.1.13. Density

10.1.14. Signal Integrity Evaluations

10.1.15. Global Warming Potential (GWP)

10.1.16. Material Compatibility Guide - Immersion Coolant and TIMs/Adhesives

10.1.17. Material Compatibility Guide - Seals/Gaskets/O-Rings and Immersion Coolant

10.1.18. Material Compatibility Guide - Plastics and Immersion Coolant

10.1.19. Material Compatibility Guide - Pipe & Fitting and Immersion Coolant

10.1.20. Material Compatibility Guide - Metal and Immersion Coolant

10.1.21. Yearly Coolant Volume for Immersion: 2022-2036

10.1.22. Overview of PFAS Types, Post-PFAS Blends, PFAS-Free Data Center Coolant Alternatives

10.1.23. Mapping Refrigerants in Use and Technology Trends

10.1.24. Adoption Forecasts and Performance Assessment

10.1.25. Comparative Advantages and Limitations

10.1.26. Regulatory barriers

10.1.27. Classes of different refrigerants

10.2. D2C Coolant

10.2.1. Refrigerants for two-phase DLC (1/2)

10.2.2. Refrigerants for two-phase DLC (2/2)

10.2.3. Compatibility for thermoplastics and elastomers

10.2.4. Properties of PG-based coolant for single-phase D2C

11. SUPPLY CHAIN, PARTNERSHIPS AND ROADMAP

11.1.1. Data Center Cooling Value Chain

11.1.2. Cooling Solution Partner

11.1.3. Summary of a few cooling solution suppliers

11.1.4. Summary of key companies and their customers

11.1.5. Summary of key ODMs and Cooling Component Suppliers

11.1.6. Market Share of Cold Plate Suppliers

11.1.7. Server Supply Chain

11.1.8. Cost Analysis of Server Cooling Components

11.1.9. Nvidia's Liquid Cooling Supply Chain - 2025

11.1.10. Intel and Submer - Heat Reuse and Immersion Cooling

11.1.11. Iceotope, Intel and HPE

11.1.12. Iceotope, Schneider Electric, and Avnet - Liquid Cooled Data Center

11.1.13. GRC and Intel

11.1.14. GRC and Dell - Edge Deployment

11.1.15. Iceotope and Meta

11.1.16. Development of New Immersion Coolant - ElectroSafe

11.1.17. Partnership - how does the value chain look like?

11.1.18. Roadmap of Liquid Cooling Adoption

11.1.19. Data Center Cooling Solution - Roadmap

12. TOTAL COST OF OWNERSHIP ANALYSIS

12.1. Cooling cost analysis

12.2. OPEX and TCO Estimation

12.3. TCO Comparison - Payback Time

12.4. Pricing of Direct-to-Chip, Immersion and Air Cooling - US$/Watt

12.5. TCO Analysis of D2C with Chiller

12.6. TCO Analysis of 1-PIC with Chiller

12.7. TCO Analysis - 10 Year

12.8. Cooling System Cost - Direct to Chip Cooling Hardware

12.9. Immersion Cooling Cost - Componentry and Facility Level

12.10. Cooling System Cost - CDUs Hardware

12.11. Cost - Fluids

12.12. Cooling System Cost - Thermal Interface Materials

13. COOLANT DISTRIBUTION UNITS (CDUS)

13.1. Overview

13.1.1. Overview

13.1.2. Trend of in-row and in-rack CDUs

13.1.3. Redundancy - (1)

13.1.4. Redundancy - (2)

13.1.5. Liquid-to-Liquid (also known as L2L) CDUs

13.1.6. Liquid-to-Air CDUs

13.1.7. Summary of Liquid-to-Liquid and Liquid-to-Air Cooling

13.1.8. Vertiv - Liebert® XDU 60 Heat Exchanger and CDU - (1)

13.1.9. Vertiv - Liebert® XDU Heat Exchanger and CDU - (2)

13.1.10. CDU - nVent

13.1.11. CDU - CoolIT - Teardown (1)

13.1.12. CDU - CoolIT - Teardown (2)

13.1.13. CDU - CoolIT - Teardown (3)

13.1.14. CDU Teardown - Motivair

13.1.15. LiquidStack's Liquid-to-Liquid Coolant Distribution Unit (CDU)

13.1.16. Boyd - Cold Plate and CDUs (1/2)

13.1.17. Boyd - Cold Plate and CDUs (2/2)

13.1.18. CDU - Cooling Capacity Evaluation

13.1.19. Revenue Forecast of CDU: 2022-2036

13.2. Main Pump

13.2.1. Overview

13.2.2. Redundancy Analysis

13.3. Filtering

13.3.1. Overview

13.3.2. Filters - Schematic Drawing

13.3.3. Filters

13.4. Sensors

13.4.1. Overview of Sensors

13.4.2. Leakage Detection Sensors - Overview

13.4.3. Leakage Detection Sensors on Server Nodes (1)

13.4.4. Leakage Detection Sensors on Server Nodes (2)

13.5. Quick Disconnects (QDs)

13.5.1. Overview of QDs

13.5.2. Wetted materials

13.5.3. Quick disconnects - costs and operating requirements

13.6. Heat Reuse

13.6.1. Overview of the Heat Reuse in Data Center Cooling

13.6.2. Use Case: Amazon Data Center Heat Reuse

13.6.3. Facebook (Now Meta) Data Center Heat Reuse

13.6.4. Tencent - Tianjin Data Center Heat For Municipal Heating

13.6.5. Return on Investment of Heat Reuse

13.6.6. More Examples of Heat Reuse

13.6.7. More Examples of Heat Reuse

14. HEAT TRANSFER - THERMAL INTERFACE MATERIALS (TIMS)

14.1. TIM2 Overview

14.1.1. Thermal Interface Materials in Data Centers

14.1.2. Common Types of TIMs in Data Centers - Line Card Level

14.1.3. TIMs in Data Centers - Line Card Level - Transceivers

14.1.4. TIMs in Server Boards

14.1.5. Server Board Layout

14.1.6. TIMs for Data Center - Server Boards, Switches and Routers

14.1.7. Data Center Switch Players

14.1.8. How TIMs are Used in Data Center Switches - FS N8560-32C 32x 100GbE Switch

14.1.9. WS-SUP720 Supervisor 720 Module

14.1.10. Ubiquiti UniFi USW-Leaf Switch

14.1.11. FS S5850-48S6Q 48x 10GbE and 6x 40GbE Switch

14.1.12. Cisco Nexus 7700 Supervisor 2E module

14.1.13. TIMs for Power Supply Converters (1): AC-DC and DC-DC

14.1.14. Data Center Power Supply System

14.1.15. TIMs for Data Center Power Supplies (2)

14.1.16. TIMs for Data Center Power Supplies (3)

14.1.17. TIMs in Data Center Power Supplies (4)

14.1.18. How TIMs are Used in Data Center Power Supplies (5)

14.1.19. How TIMs are Used in data center power supply (6)

14.1.20. TIMs for Data Centers - Power Supply Converters

14.1.21. Differences Between TIM Forms - (1)

14.1.22. Differences Between TIM Forms - (2)

14.1.23. Novel material - Laminar Metal Form with High Softness (1)

14.1.24. Novel material - Laminar Metal Form with High Softness (2)

14.1.25. TIM Trends in Data Centers

14.1.26. Estimating the TIM Areas in Server Boards

14.1.27. Servers Number Forecast: 2021-2035

14.1.28. TIM Requirement in Immersion Cooling

14.1.29. Common TIMs for Immersion Cooling

14.1.30. Area of TIM per Switch

14.1.31. TIM Area for Leaf and Spine Switch

14.1.32. Yearly TIM Area for Leaf and Spine Switch Forecast: 2026-2036

14.1.33. TIM Consumption in Data Center Power Supplies

14.1.34. Forecast summary - Yearly TIM Area (m2) Forecast for Different Data Center Components: 2026-2036

14.1.35. Forecast summary - Yearly TIM Revenue (US$ millions) Forecast for Data Center Components: 2026-2036

14.2. TIM1 and TIM1.5 in advanced semiconductor packaging

14.2.1. Thermal interface material inside the packaging - TIM1

14.2.2. Potential TIM1 options in the future

14.2.3. TIM1 Considerations

14.2.4. Indium foil TIM1 - issues with multiple reflow process

14.2.5. Traditional and mature product - Shin-Estu X-23 series for BGA

14.2.6. Thermal Gel - Shin-Etsu MicroSi

14.2.7. TIM1 and TIM1.5 market size forecast for ASP: 2026-2036

15. FORECAST SUMMARY

15.1. Yearly Revenue Forecast By Cooling Method: 2022-2036

15.2. Yearly Revenue Forecast By Cooling Method - Data Table: 2022-2036

15.3. Summary of Yearly Revenue Forecast for Liquid Cooling: 2022-2036

15.4. Summary of Yearly Revenue Forecast for Liquid Cooling Data: 2022-2036

15.5. Summary of Yearly Volume Forecast for Liquid Cooling: 2022-2036

15.6. Summary of Yearly Volume Forecast for Cooling - Data Table: 2022-2036

16. PROFILES

16.1. Accelsius — Two-Phase Direct-to-Chip Cooling

16.2. Amazon AWS Data Center

16.3. Arieca

16.4. Arieca

16.5. Asperitas Immersed Computing

16.6. Calyos: Data Center Applications

16.7. Engineered Fluids

16.8. Green Revolution Cooling (GRC)

16.9. Henkel: microTIM and data centers

16.10. LiquidCool Solutions — Chassis-Based Immersion Cooling

16.11. LiSAT

16.12. LiSAT

16.13. Nano-Join

16.14. NeoFan

16.15. Neurok Thermocon Inc

16.16. Parker Lord: Dispensable Gap Fillers

16.17. Resonac Holdings

16.18. Sumitomo Chemical Co., Ltd

16.19. Taybo (Shanghai) Environmental Technology Co., Ltd

16.20. Tyson

16.21. Vertiv Holdings - Data Center Liquid Cooling

16.22. ZutaCore

ご注文は、お電話またはWEBから承ります。お見積もりの作成もお気軽にご相談ください。本レポートと同分野(半導体)の最新刊レポート

IDTechEx社の 半導体、コンピュータ、AI - Semiconductors, Computing & AI分野 での最新刊レポート

よくあるご質問IDTechEx社はどのような調査会社ですか?IDTechExはセンサ技術や3D印刷、電気自動車などの先端技術・材料市場を対象に広範かつ詳細な調査を行っています。データリソースはIDTechExの調査レポートおよび委託調査(個別調査)を取り扱う日... もっと見る 調査レポートの納品までの日数はどの程度ですか?在庫のあるものは速納となりますが、平均的には 3-4日と見て下さい。

注文の手続きはどのようになっていますか?1)お客様からの御問い合わせをいただきます。

お支払方法の方法はどのようになっていますか?納品と同時にデータリソース社よりお客様へ請求書(必要に応じて納品書も)を発送いたします。

データリソース社はどのような会社ですか?当社は、世界各国の主要調査会社・レポート出版社と提携し、世界各国の市場調査レポートや技術動向レポートなどを日本国内の企業・公官庁及び教育研究機関に提供しております。

|

|