AIチップ (機械学習チップ)はどこから来て、どこへ行く?

AIチップ (機械学習チップ)はどこから来て、どこへ行く?

1. 序

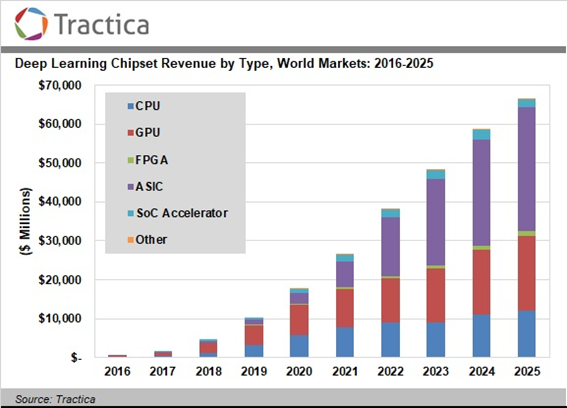

Tractica社によると、ディープラーニング用チップセット市場は、

– 技術的にはCPU/GPU/FPGA/ASIC/SoC/その他の混合市場

– 当初はGPUが主流だが、今後はASICの比重も高くなる

– 数量ベースでは2017年の$1B (1000億円)から2025年には$66B (6.6兆円)超に拡大

と見られている。

この市場はどのような構造になっており、何が市場を牽引しているのであろうか? 今後、どのようになっていくのであろうか?

今回はその事を探る。

出典:Tractica社 (2018年3月発表)

図1-1- ディープラーニング用チップセット市場規模予測

2. AI導入形態 – 現状

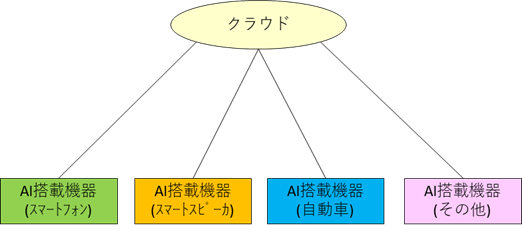

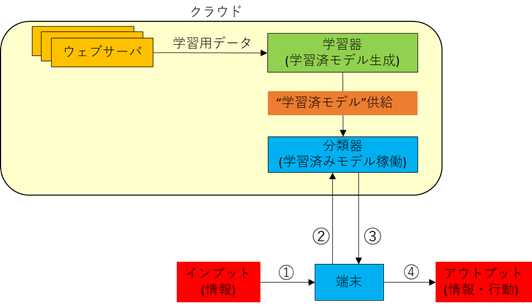

AI機能はトライルも含めて多くのシーンで使われてはじめているが、その実装形態は下図のようになっている。

図2-1- AI実装形態

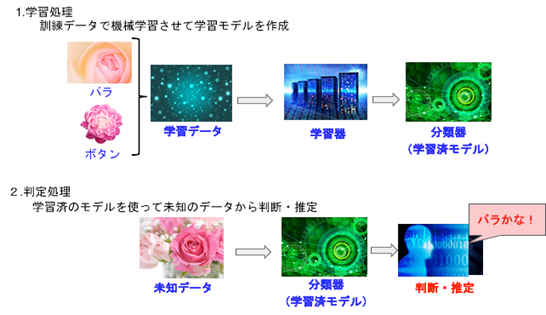

しかし、この図をAI機能の視点から示すと、学習器と分類器に分かれ、下図のようになる。

出典:株式会社システムインテグレータ

図2-2- 学習処理部と判定処理部

現在、AIチップの半導体化の動きが活発になっていますが、それは、ニューラルネットワーク (NN) という機械学習アルゴリズムの半導体化であり、その学習器・分類器の半導体化を意味しています。

3. AI機能 (機械学習機能・NN)のチップ化の動き

3.1. NNの半導体化・チップ化の動き

2012年6月、「コンピュータが猫を認識できるようになった」というGoogleの発表が世界で話題になりました。

これは、

– 1.6万個のCPU (16コア CPU×1000個)で構成されるPCクラスタにて

– 学習器を構築し、1000万枚の200×200ピクセルの猫の画像を入力して、猫を認識する学習済モデルを三日間かけて制作し。

– かつ、同一PCクラスタ上で、9層のニューラルネットワークで構成される分類器を構築し学習済モデルを展開して、写真分類を実施した

ということを意味しています。

ちなみに・・・

この発表に関する一連の記事には学習器・分類器といった区別はありません。学習器・分類器はこの同じPCクラスタ上で構築されていると、ここでは推測しています。

そして、この学習済分類器が、一つの画像を見て、それを猫と判断するために費やした時間に関する情報も公開されていません。一体、どのくらい、かかったのでしょうか。知りたいものです。

さて、その後、ハードウェアをCPUからGPUに変えることで演算装置を劇的に増やすことが可能になりニューラルネットワークも高機能化し、AIによる画像処理は急激に進歩し、実験レベルから実用レベルになりつつあります。

NVIDIAが独走している領域はここになります。

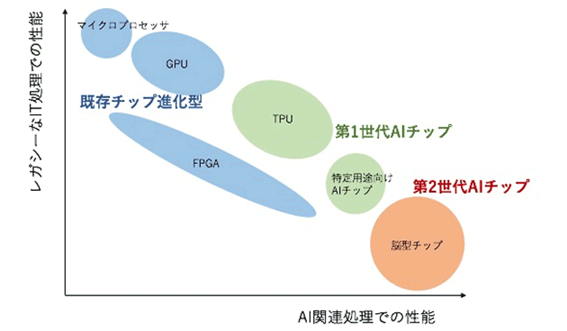

一方、2016年5月、Googleが「ディープラーニング専用プロセッサ、Tensor Processing Unit(TPU)」を発表しました。Googleは、ディープラーニングに特化したTPUは、汎用目的のGPUやFPGAに比較して「消費電力当りの性能は10倍」と発表しています。

ニューラルネットワークの展開先は、サーバからASICへの拡大しつつあります。

この状況を図にすると下図のようになります。

出典:伊藤元昭氏

図3-1- AIチップの系統分類

3.2. AI機能の階層化・分化とNNの半導体化の動き

AI実用化初期は、スマートフォンにも代表されるように、学習器・分類器が共にクラウド上にありました。そして、それぞれの機能がクラウドサーバ上で展開されていました。

出典:筆者

図3-2- 学習器・分類器配置図 (AI導入初期)

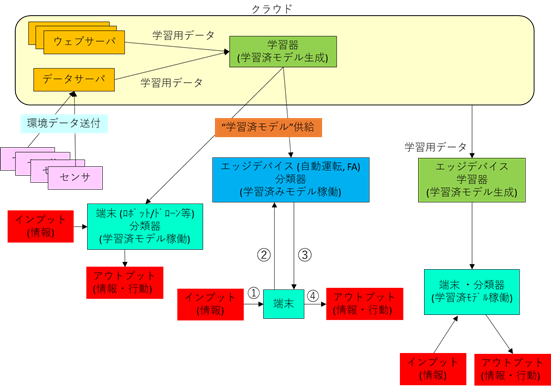

しかしながら、最近では、

– 素早いレスポンスタイムが要求されるアプリケーションへの対応

– 通信量の削減・通信コストの削減

– 社内コンプライアンスによるデータ管理の制限

等の理由により、分類器をエッジデバイスや端末に展開するケース、学習器をエッジデバイスに展開するケースも増えてきています。(図2-5参照)

このような場合、処理時間の短縮やスペース・消費電力の制約を回避するため、あるいは、処理項目が限定される事での負荷軽減により、半導体チップでも対応できるケースが増えてきています。

出典:筆者

図3-3- 学習器・分類器配置図 (最近の傾向)

このような需要に向けて、CPUベンダー、GPUベンダー、ソフトウェアベンダー、サービスプロバイダ、スタートアップを含む多くの企業が参入し、以下アプリケーションに向けて半導体ソリューションを提供しています。(以下表参照)

– データセンタ内学習器

– エッジデバイス内学習器

– エッジデバイス内分類器

– 端末内分類器

表3-A

| 開発元 | 製品名/出荷開始時期 | 特長 |

| アリババ

(Alibaba) |

Ali-NPU/未公表 | データセンタ向け分類器

画像や動画の分析等のタスク処理向け |

| Amazon | ― | Echo搭載用 (2018年2月にメディア推測記事) |

| Apple | Neural Engine/出荷中 | iPhoneX搭載分類器 (A11 Bionic) |

| ARM | ARM ML Processor

2018年中頃 |

IPコア。NVIDIAと提携

モバイル機器/スマートホーム機器向け エッジデバイス向け学習器 |

| ARM OD Processor

2018年中頃 |

IPコア。NVIDIAと提携

モバイル機器/スマートホーム機器向け 端末向け分類器 |

|

| CEVA | NeuProファミリー

2018年第三四半期 |

IPコア

エッジデバイス向け分類器 |

| ― | 2018年4月チーム作り開始 | |

| 富士通

(Fujitsu) |

DLU/2019年3月 | 分類器

データセンタ向け分類器 (PC/サーバ搭載) |

| TPU/2015年春 | データセンタ向け学習器。「TensorFlow」対応

AlphaGo/Google Cloud MLで利用 |

|

| Intel | Myriad X/2017年8月 | 端末向け分類器 (ドローン/ロボット) |

| Loihi/2018年テストチップ | エッジデバイス向け学習器 | |

| Microsoft | HPU2.0/2019年 | HoloLens v2(仮称)に搭載

端末向け分類器 |

| BrainWave

(2017年8月発表) |

FPGA上で動作

データセンタ向け学習器 Microsoft) CNTK、Google) Tensorflowに対応 |

|

| NVIDIA | Quadro GV100/

2018年3月 |

GPU

データセンタで学習器として使用 Amazonがデータセンタでトレーニングエンジンとして使用 |

| ARM参照 | アクセラレータのIPをARMに提供 |

公表されている主な企業の機械学習チップの動向を上記表にて、整理しましたが、

– サービスプロバイダや端末メーカは分類器の半導体を発表 (学習器への取組みは発表せず)

– 半導体メーカは、学習器・分類器双方の半導体化を発表

という傾向にあるようです。

4. 機械学習チップの実用化の今後の動き – 予想

4.1. 多彩なNNに最適化された機械学習チップが登場

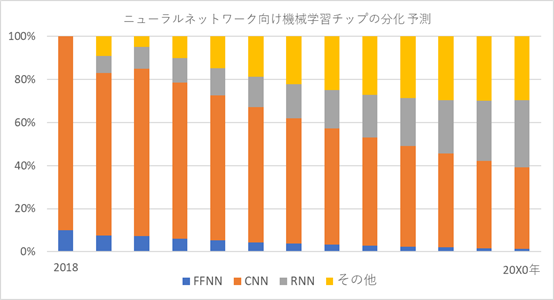

まず、NNといっても、実際には

– 順伝播型ニューラルネットワーク(Feed Forward Neural Network: FFNN)- NNの基本

– 畳み込みニューラルネットワーク(Convolutional Neural Network: CNN)- 画像認識用

– 再帰型ニューラルネットワーク (Recurrent Neural Network: RNN) -文脈理解

– 確率的ニューラルネットワーク(PNN: Probabilistic Neural Network)-因果関係推論

を始めとして、様々なモデルがあります。

今後、画像認識向けにCNNに最適された機械学習チップ、又、会話向けにRNNに最適化された機械学習チップの実用化も予想されます。(下図参照)

出典:筆者

図4-1- NN向け機械学習チップの分化予測

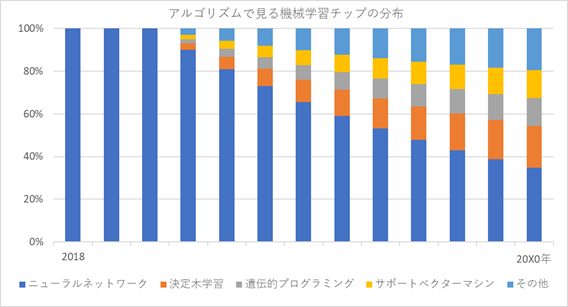

4.2. SVM等のNN以外のアルゴリズムに最適された機械学習チップが登場

AI機能の実現方法の手法として、今は、NNを汎用サーバ (CPU・GPU)に実装することだけでなく、NNに最適化されたASICでAI機能を実装する方向に拡大しつつあります。

しかし、AIの実現手法としては、NNだけではなく、決定期学習や、遺伝的プログラミング、サポートベクターマシンといった手法もあります。

用途としても、エキスパートシステム、データマイニング、データ分類、プランニング等があります。今後は、用途と機械学習に合わせて、それに最適化された機械学習チップの実用化も予想されます。

物量的に急激に拡大するが、用途開拓に伴い、チップとしての多様化が進むと予想されます。(下図参照)

出典:筆者

図4-2- アルゴリズで見る機械学習チップの分布

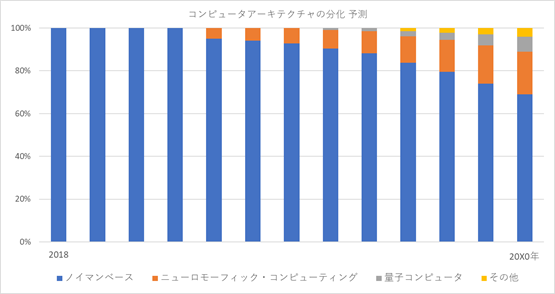

4.3. ニューロモフィック・コンピュータや、量子コンピュータがAI機能を実現

本来、ニューラルネットワークは、人間の頭脳のデータ処理の動きのモデル化です。

一方、コンピュータハードウェアのアーキテクチャとして、人間の頭脳を参考にした「ニューロモーフィック・コンピューティング」の研究が、かねてよりなされています。

今、ニューラルネットワークが搭載されているCPU/GPU/ASICはノイマン型コンピュータアーキテクチャに基づいており、本来的には、親和性という観点からは、ニューラルネットワークは、「ニューロモーフィック・コンピューティング (脳型チップ)」との間の方が、親和性が高いと考えられます。

長期的には、ニューラルネットワークで実現されるAI機能は、「ニューロモーフィック・コンピューティング(脳型チップ)」に移行すると考えられます。

同様に、遺伝的アリゴリズムに基づくAI機能は、量子コンピュータ等によって実現されることも考えられる。

そのように考えると、AI機能の用途により、いくつかのコンピュータアーキテクチャが、今後、採用されることも考えられます。(下図参照)

出典:筆者

図4-3- コンピュータアーキテクチャの分化予測

5.最後に

ソフトウェアで実現されていた学習器・分類器が、これからは、処理速度・消費電力・実装空間等からの制約により半導体によって実現されることになります。

巷では「すべてはソフトウェア化する」というキャッチフレーズが飛び交い、ある種のイメージが氾濫しているが、実際にはそうではない事も多々あります。

日本のITベンダー・サービスプロバイダは、「ソフトウェアの時代」、「ソリューションの時代」というキャッチフレーズ的な言葉に踊らされ、半導体やコンピュータハードウェア・アーキテクチャの比重を下げてきました。

今一度、半導体やハードウェアの重要性を見直すことが求められていると思われます。

筆者:株式会社データリソース客員研究員 鈴木浩之 (ICTラボラトリー代表)

——————————————————————————————————————–

データリソース社が推奨する市場調査レポート

– 世界の深層学習(ディープラーニング)向けチップセット市場の分析と予測:トレーニングと推論用途向けCPU、GPU、FPGA、ASIC、SoCアクセラレータとその他のチップセット

- 調査会社:Tractica LLC. 発行時期:2018年5月

– 人工知能(AI)の市場:プラットフォーム毎、コンポーネント毎、採用モード毎、用途毎、産業垂直市場毎 2018-2023年

- 調査会社:Mind Commerce 発行時期:22018年5月

– 世界のAI画像認識市場:タイプ別(ハードウェア、ソフトウェア、サービス)、エンドユーザ垂直市場別(自動車、医療、製造)、地域別:成長性、動向、予測 (2018 – 2023)

- 調査会社:Mordor Intelligence 発行時期:2018年4月

- 調査会社:Tractica LLC. 発行時期:2018年4月

- MarketsandMarkets 発行時期:2018年2月

キーワード

AIチップ、ニューラルネット、学習処理、推論処理、ニューロチップ、深層学習、ディープラーニング、ニューロモーフィックチップ、ノイマン型コンピュータ、学習器・分類器、サポートベクターマシン、ベイジアンネットワーク、